Definindo uma função

Uma função é uma regra que associa um conjunto de elementos com outro (há maneiras mais rigorosas de definir mas por agora basta isto). Temos um conjunto D onde cada um de seus elementos esta associato com outro elemento de um outro conjunto, o E. O conjunto D é chamado de Domínio da função e o conjunto E de contradomínio da função. Cada elemento de D é chamado de entrada ou variável independente e cada elemento de E é chamado de saída ou variável dependente.

Caso o termo dependente cause confusão quando temos uma função constante, isto é, uma função que produz o mesmo valor para qualquer entrada. A função constante só pode calcular um valor se uma variável de entrada existir, qualquer que seja. Sem valor de entrada a função não tem saída nenhuma.

Para várias variáveis a definição de função é a mesma. Exceto que agora temos uma questão adicional: as variáveis independentes são independentes entre si? Em cálculo sim. Mas podemos muito bem pensar em muitas situações onde as variáveis independentes guardam alguma dependência entre si. Para tudo que aprendemos em cálculo, [math]\displaystyle{ f(x,y) = x + y }[/math] por exemplo. Considerando o domínio da função, os valores de cada par [math]\displaystyle{ (x,y) }[/math] não tem nenhuma dependência entre uma variável e a outra. Em álgebra linear esta independência de variáveis é chamada de "independência linear".

A flecha é uma forma bem intuitiva de mostrar que os elementos de D são levados a elementos de E. Note que cada elemento de D deve corresponder a algum elemento de E. Se houver algum de D que não, então ele não faz parte do domínio. Note também que cada [math]\displaystyle{ x }[/math] corresponde a um [math]\displaystyle{ f(x) }[/math], o que significa que são todos pares ordenados [math]\displaystyle{ (x, \ f(x)) }[/math]. Ordenados porque, como a flecha indica, a direção importa. Você não pode simplesmente escrever um par em qualquer ordem porque fazendo isto você estará destruindo a relação dos elementos.

Notação: [math]\displaystyle{ f \ : D \ \to \ E }[/math]. Na maior parte do tempo não precisamos escrever isso e escrevemos apenas [math]\displaystyle{ f(x) = x^2 + 3x - 5 }[/math] porque é bastante óbvio pela própria equação que representa a função quais são os conjuntos D e E. Quando traçamos o gráfico de uma função não importa se o eixo vertical for chamado de [math]\displaystyle{ f(x) }[/math] ou [math]\displaystyle{ y }[/math]. Apenas é mais comum usar [math]\displaystyle{ x, \ y }[/math] para nomear os eixos (e [math]\displaystyle{ z }[/math] no caso de funções de duas variáveis).

A flecha pode ser invertida? Sim, este é o conceito da função inversa. Porém, nem toda função pode ser invertida e alguns processos não são reversíveis (há muitos exemplos de processos irreversíveis na física e na química). A condição para que uma função seja invertível é que para cada [math]\displaystyle{ f(x) }[/math], corresponde apenas um [math]\displaystyle{ x }[/math], tal que [math]\displaystyle{ x \to f(x) }[/math]. Em outras palavras, de [math]\displaystyle{ x }[/math] vamos à [math]\displaystyle{ f(x) }[/math] e vice-versa. Se acontecer isto [math]\displaystyle{ x_1, \ x_2 \to f(x) }[/math], é impossível saber a partir de [math]\displaystyle{ f(x) }[/math] se partimos de [math]\displaystyle{ x_1 }[/math] ou [math]\displaystyle{ x_2 }[/math]. Ou seja, a função não é invertível.

Uma questão natural sobre as funções inversas: não aprendemos o teorema na escola, mas podemos aprender o significado de uma função inversa. O que fazer no caso de funções de várias variáveis? O conceito é o mesmo, mas entra uma complicação. O domínio de uma função de uma variável (real) é um conjunto de números ordenados. O domínio de uma função de duas variáveis é um conjunto de pares ordenados. Com funções de várias variáveis há infinitos pares ordenados que são levados ao mesmo valor. O que fazer? Não é possível explicar aqui com um parágrafo só.

Uma analogia: suponha que tenhamos uma máquina que processa água, energia, açúcar, aromatizantes e glucose de milho para produzir doces. A máquina só produz doces. Não pode produzir, digamos, bolos com os mesmos ingredientes usados para produzir doces. Por outro lado, se introduzirmos sal, amido de milho e morangos na mesma máquina, ela não produzirá nada porque não foi feita para processar morangos, sal e amido de milho.

Sobre a terminologia:

Note about terminology: In many places you see the words "parameter", "argument" and "unknown". For the most part they always mean the input variable. Parameter is often found when we have equations, specially with a geometrical meaning. Because increasing or decreasing its value makes a circle larger or changes the slope of a line for example. Now in physics, the variables often have some meaning, such as changing the rate of some variation for instance. A practical example would be equations that describe how a certain material is transparent to visible light. It can be more transparent or less transparent and that property is usually governed by a parameter. The word "argument" is most common in mathematics to refer to function's arguments. Now "unknown" is a synonym for "variable" most of the time, it's more common when we talk about solving equations or system of equations.

Codomain and image: for the most part in calculus, in english textbooks, range is a synonym for both. There seems to be some differences among textbooks and in between english and portuguese. For the definition of domain the word doesn't cause confusion. What would be the codomain? I'm going to borrow a word from psychology which is "codependency". The set of all dependent variables is contained in which set? In portuguese language textbooks it's the counterdomain (I have no idea why in portuguese the term is almost the opposite of the english term). Analogous to the psychology term, the codomain depends on the domain. Now for the term image, I have a textbook that defines that [math]\displaystyle{ (x, \ f(x)) }[/math]. [math]\displaystyle{ f(x) }[/math] is called the image of [math]\displaystyle{ x }[/math]. If we think about the word image, it gives the idea that [math]\displaystyle{ x }[/math] is what goes in the function, which processes it and produces something that we can see, the image. That would be a point in the function's graph. The set of all images and the codomain can be the same, but the image can never go over the codomain. One example is [math]\displaystyle{ f(x) = x^2 }[/math]. It's a function that maps real numbers to real numbers. The codomain is all real numbers, but the function cannot produce negative numbers, its image is [math]\displaystyle{ \mathbb{R}_*^{+} }[/math].

Physical interpretation: We are often not interested in all values of a function but just a particular range. For example: a function may represent volume in respect to something. The function itself can assume negative values. However, a negative volume doesn't exist. Another example: speed over time. Due to the laws of physics, speed can't be an infinitely large quantity, there is the upper limit of the speed of light. We can, nonetheless, plot the graph. It just won't have any physical meaning beyond the speed of light. That's where pure math comes in, where the physical meaning of a function is lost.

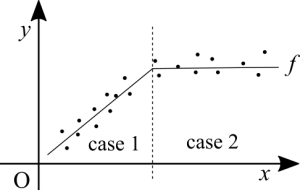

Functions from data points: in Calculus, most of the time, you are given the function. In many scenarios the function is unknown. What is known is the data. If the data is nicely ordered on a table, numerical patterns may be quickly noticed. Easy patterns such as periodic oscillations, increasing at a constant rate, at an exponential rate or decreasing exponentially. If an easy pattern cannot be identified, you'd have to plot the data on the Cartesian plane to see if there is any noticeable pattern. This is more or less an exercise of guessing which of the known functions seems to best approximate the data's behaviour.

In experimental physics, most of the time you already know the function. The classes aren't about trying to guess which function is it. The experiments done already give you the function and the goal of it is more about testing the limits in which that function remains a good approximation for the data that you gather. In those experiments there are tiny bits of statistics because there is some error analysis to be performed on the data.

In practical terms, data can also display bizarre behaviour, in which case one's knowledge about the phenomena is what makes those bizarre behaviours to be spotted. For example: the speed of sound in air is known. If there is a table and one point depicts an excessively high speed. It either means that the data itself is wrong due to some collection error or that somebody inserted data that shouldn't have been there. For statistics those points may be relevant, such as whether they represent an error or a spike. A spike in crime rates for instance?